在前面的文章里,我写了好几篇关于,文生视频和图生视频文章,

分享了不同的工具,有内测完全免费的,当然也有收费的,但是有一定的免费额度。

想了解的,可以点以下链接查看,是否合适自已使用:

以上都是往期分享的工具,都是可以在Discord里使用。

这些都是在线的,那么有没有本地部署使用呢?

因为本地部署使用,对于有高配置硬件的伙伴,就非常有必要了,

本地速度快,而且还免费无限使用;

今天,就分享一个基本SD的文生图插件:AnimateDiff

什么是AnimateDiff

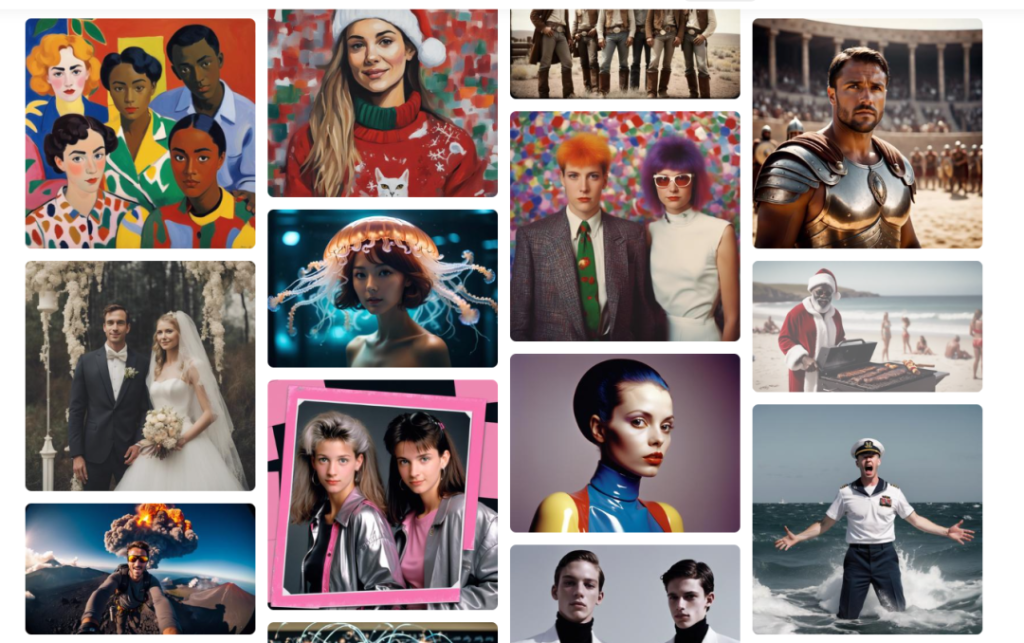

AnimateDiff 是一种基于控制模块的图像生成技术,它影响 Stable Diffusion 模型。

通过大量短视频剪辑的训练,对图像生成过程进行调整,使生成的图像序列更符合训练视频剪辑的特点。

AnimateDiff 通过优化图像之间的过渡,确保生成的视频帧具有流畅性。

与传统的 SD 模型训练方式有所不同,AnimateDiff 通过大量短视频的训练来提高图像之间的连续性。

这种方法使得生成的每一张图像都能够经过 AnimateDiff 的微调,最终形成高质量的短视频。

通过训练,AnimateDiff 实现了对图像生成过程的精准控制,为用户提供更加令人满意的视觉体验。

二、安装方法

为了使用 AnimateDiff 插件,首先需要确保 WebUI 已经升级到 v1.6.0 版本。

1、安装插件

然后具备网络环境的情况下,通过链接(https://github.com/continue-revolution/sd-webui-animatediff)安装 sd-webui-animatediff 插件扩展。如下图所示;

2、下载模型

同时,下载模型的 ckpt 文件,并将其放置在 stable-diffusion-webui/extensions/sd-webui-animatediff/model/ 目录下。

可以在 Hugging Face 代码库下载链接:

(https://huggingface.co/guoyww/animatediff)中找到可用的 ckpt 模型和 LoRA 模块。

请注意,mm_sd_v15_v2.ckpt 仅支持 SD1.5 模型。如果要使用 SDXL,需要下载 mm_sdxl_v10_beta.ckpt 模型。

这一系列的安装设置,可提供 AnimateDiff 插件的完整功能,确保可以充分体验图像生成的精准控制和优化。

3、重启SD

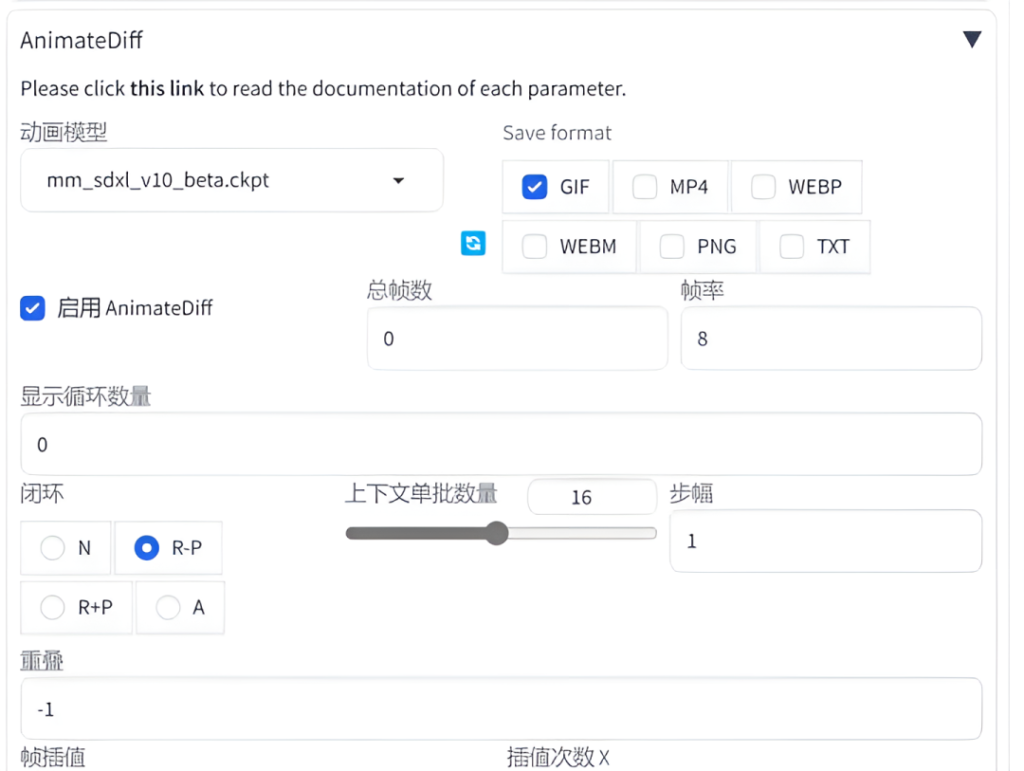

安装成功后,请重新启动 Stable Diffusion。在文生成图页面,您将看到 AnimateDiff 插件配置选项。

通过这些配置,您可以对 AnimateDiff 进行进一步的调整和个性化设置,以满足你的图像生成需求。确保你熟悉这些配置选项,以充分发挥 AnimateDiff 插件的功能,创造出更加令人惊叹的图像效果。

参考文献:

-

github:

https://github.com/guoyww/animatediff/

-

sdwebui:

https://github.com/continue-revolution/sd-webui-animatediff

-

colab:

https://colab.research.google.com/github/camenduru/AnimateDiff-colab/blob/main/AnimateDiff_colab.ipynb

-

技术论文:

https://arxiv.org/pdf/2307.04725.pdf

-

相关文献:

暂无评论内容